【SAMRS: Scaling-up Remote Sensing Segmentation Dataset with Segment Anything Model】

本篇文章是个人看文献的一些总结和个人的想法,都是个人看过文章之后的理解,不保证一定是对的,如果我的理解有错,欢迎纠正。

(2023.5.3)

遥感数据集面临的问题

SAM模型向人们展示了机器学习中数据的重要性。

在遥感(RS)图像中,标注数据困难并且有高成本,目前有许多有价值的RS数据集仍然未被标注,特别是在像素级别的标注。

SAM在RS图像中的分割效果:

文章利用SAM和现有的RS目标检测数据集,开发了一个高效的流程生成大规模RS的分割数据集,称为SAMRS。

SAMRS数据集包含105,090张图像和1,668,241个实例,规模远超现有高分辨率RS分割数据集。数据集提供了对象类别、位置和实例信息,可用于语义分割、实例分割和目标检测。

可以通过向SAM提供关于目标对象的一些提示信息,就能让SAM在图像中找到并分割出这些对象。

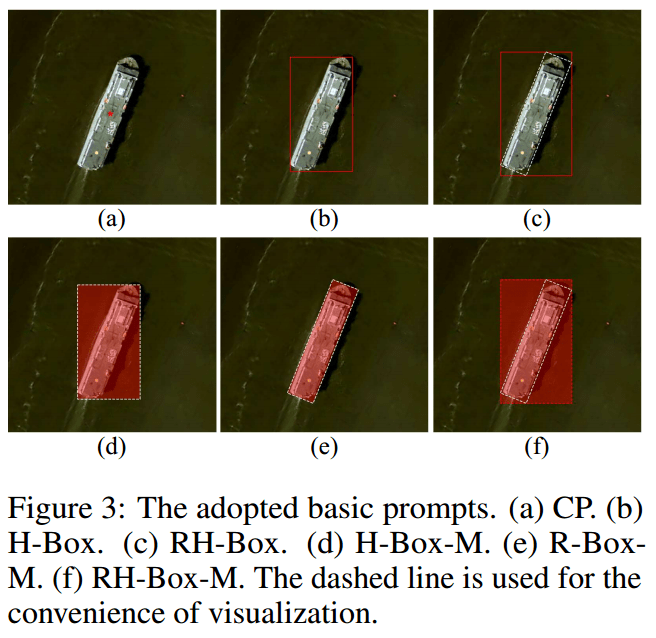

六种基本提示方式:

中心点(CP)

水平边框(H-Box)

最小外接水平矩形(RH-Box)

水平边框的掩码提示(H-Box-M)

旋转边框的掩码提示(R-Box-M)

最小外接水平矩形的掩码提示(RH-Box-M)

由于遥感图像中的目标可能具有任意方向,因此除了通常的水平边框(H-Box)外,还考虑了定向边框或旋转边框(R-Box)作为提示。但是,SAM不直接支持R-Box提示,因此使用R-Box的最小外接水平矩形(RH-Box)来代替。

数据集介绍

文章使用了四个公共遥感目标检测数据集,分别是HRSC2016、DOTA-V2.0、DIOR和 FAIR1M-2.0,通过转换这四个数据集去构建了SAMRS数据集。

HRSC2016:主要用于船只检测,仅包含一个类别。

在转换过程中,根据实验结果选择最合适的提示类型用于SAM进行标注。

DOTA-V2.0:一个大规模的遥感目标检测数据集,包含多种目标类别。

转换前,通常将DOTA数据集中的图像裁剪为1024 × 1024像素的块。直接采用H-Box提示进行转换,生成相应的分割标注。

DIOR:另一个大规模遥感目标检测数据集,具有丰富的目标类别。

采用与DOTA相同的H-Box提示进行转换。

FAIR1M-2.0:一个细粒度目标识别数据集,包含高分辨率的遥感图像。

由于该数据集仅包含R-Box标注,因此使用对应的RH-Box提示进行转换。

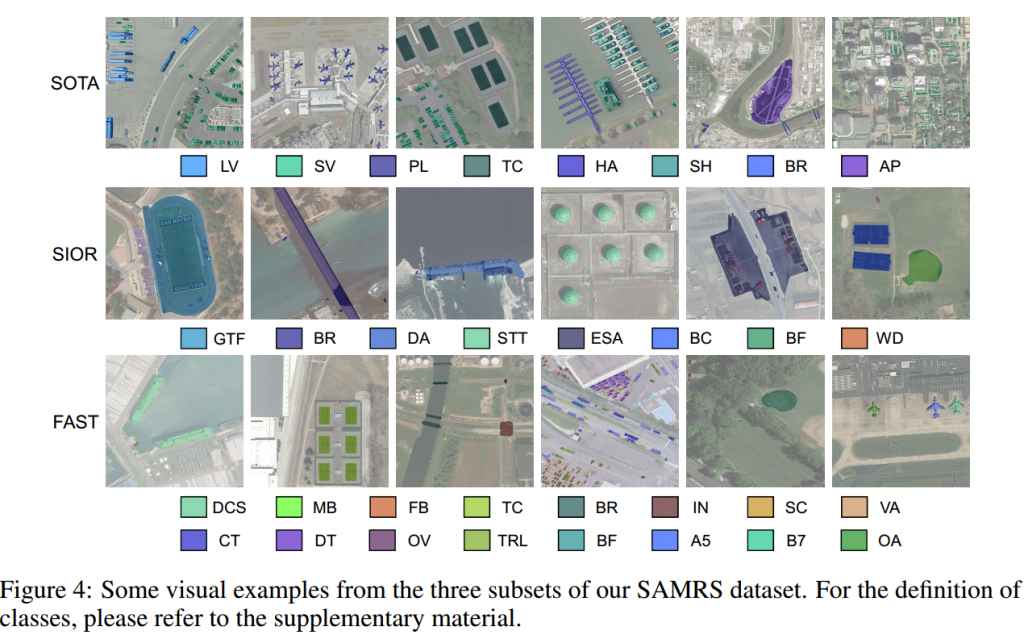

SAMRS中来自各个数据集中的类别示例:

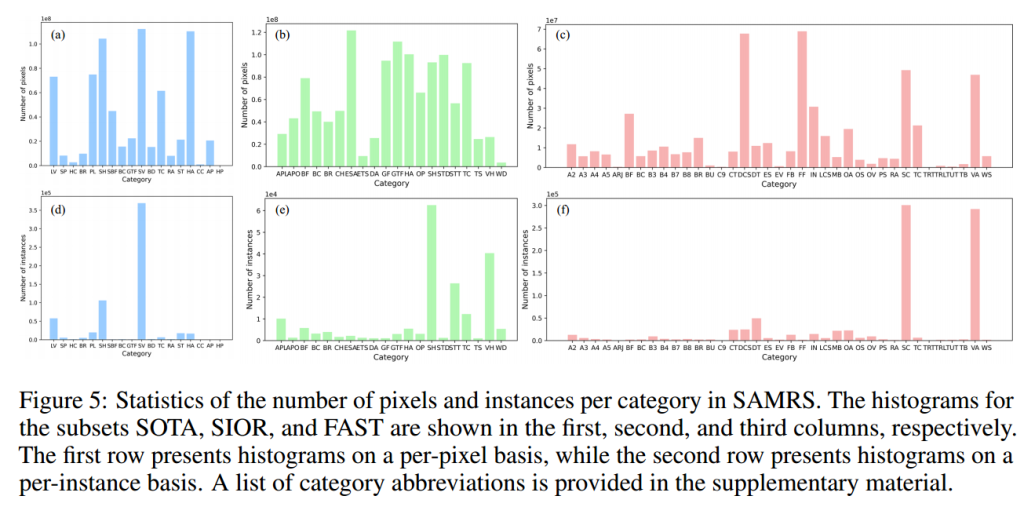

SAMRS中各个类别的数量统计:

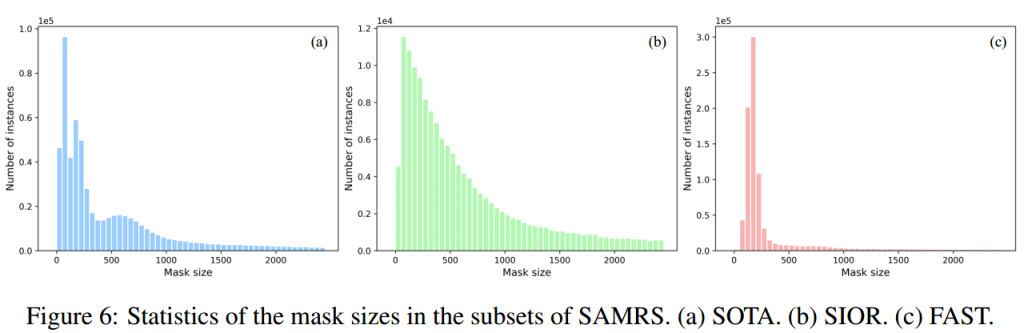

SAMRS中各个子集的掩码大小统计:

实验部分

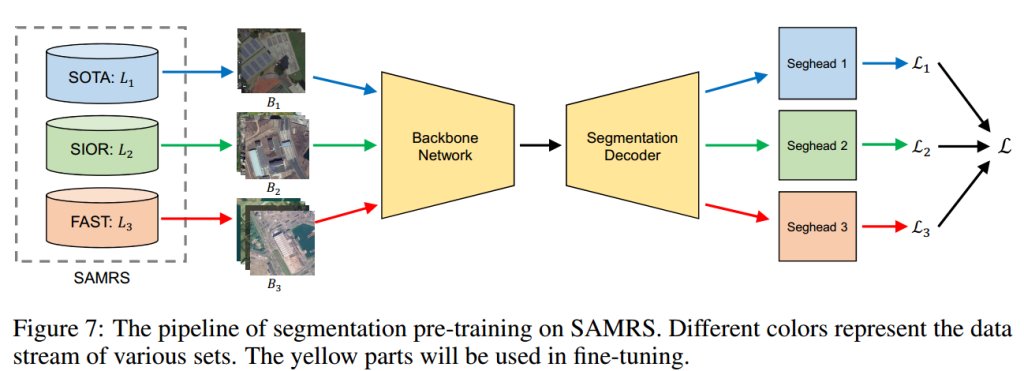

为了研究SAMRS对分割预训练(SEP)的影响,文章采用了多种分割框架进行实验。

分割解码器中,使用经典的UNet和常用的UperNet分割框架。

骨干网络(Backbone Network)中包括分层的视觉Transformer(如Swin、ViTAEv2、InternImage)和非分层网络(如ViT、ViT-Adapter、ViT-RVSA)。

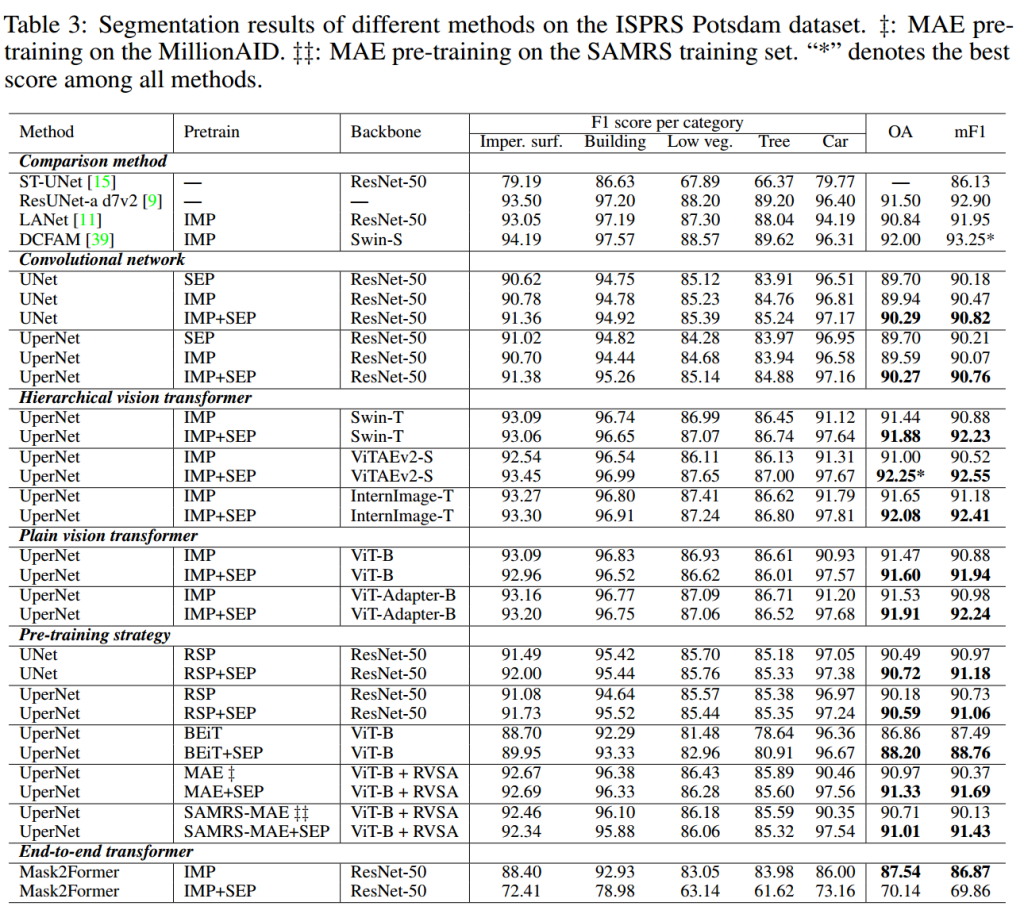

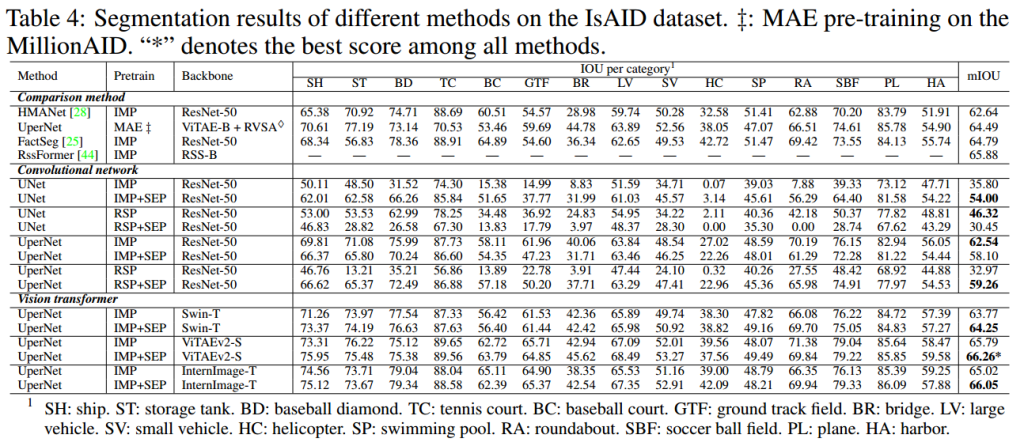

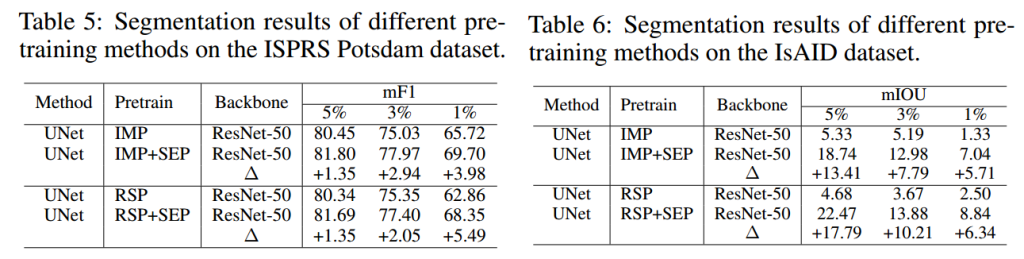

不同方法使用SAMRS训练的结果:

限制和未来的工作:

- SAMRS 尽管比现有高分辨率遥感分割数据集大,但仍小于如 ImageNet 这样的预训练分类数据集。

- 当前研究仅对小规模模型进行预训练,未来将尝试更大规模的模型。

- 研究主要关注遥感分割任务,未来应探索预训练对实例分割和目标检测任务的影响。

- 尽管有些数据集证明了分割和检测标签共存的可行性,但将现有遥感检测数据集转换为 SAMRS 仍有挑战。