【SurgicalSAM: Efficient Class Promptable Surgical Instrument Segmentation】

本篇文章是个人看文献的一些总结和个人的想法,都是个人看过文章之后的理解,不保证一定是对的,如果我的理解有错,欢迎纠正。

(2023.12.21)

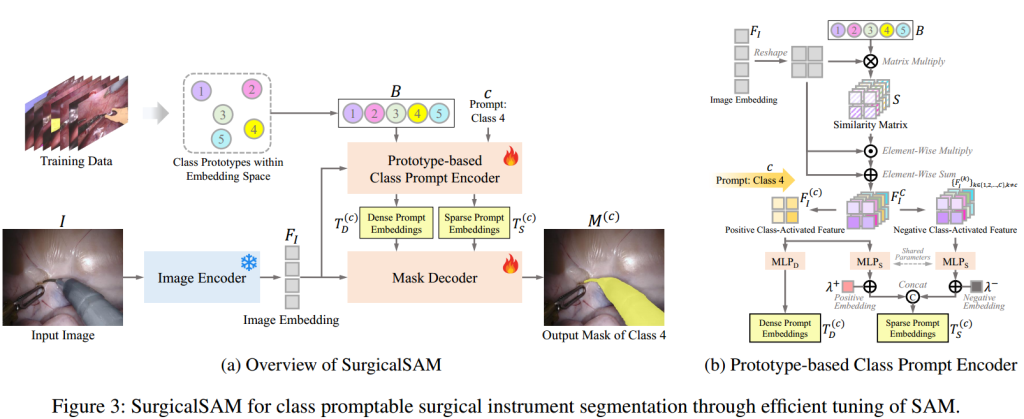

介绍了一种名为SurgicalSAM的新型端到端高效调优方法,用于改善SAM在手术器械分割任务中的泛化能力。

将SAM应用于手术器械分割时,存在两个问题:1)自然物体与手术器械之间的领域差异导致SAM泛化性能不佳;2)SAM依赖于精确的点或框位置进行准确分割,这需要复杂的多阶段流程。

为了解决这些问题,SurgicalSAM提出了一种轻量级的基于原型的类提示编码器,直接从类原型生成提示嵌入,无需显式的提示,提高了鲁棒性并简化了流程。

SurgicalSAM由三个主要部分组成:图像编码器、基于原型的类提示编码器和掩码解码器。

基于原型的类提示编码器(Prototype-based Class Prompt Encoder):

利用图像和类原型之间的相似性来创建提示嵌入。

类原型银行B(prototype bank B)包含每个类别的代表性原型。

相似性矩阵(Similarity Matrix)S通过计算图像嵌入与所有类别原型的点积来生成,用于激活图像中类特定的区域。

类激活特征(Class-Activated Feature)使用相似性矩阵作为空间注意力,激活所有类别的类特定区域。

最后提示嵌入,包括密集提示嵌入和稀疏提示嵌入,分别通过多层感知机(MLP)生成。

为了提高类原型的区分性,使得模型能够更准确地识别和激活手术器械的类别,文章采用对比原型学习(Contrastive Prototype Learning)。通过对比学习,增强原型与正样本的相似性,同时抑制与负样本的相似性,从而获得更具区分性的原型表示。

在调优过程中,大型图像编码器被冻结,只更新轻量级的基于原型的提示编码器和掩码解码器的参数。

损失函数由两部分组成,用于分割的dice损失和用于原型学习的原型对比损失。

实验部分:

使用EndoVis2018和EndoVis2017数据集进行验证,这两个数据集提供了多个手术视频帧,涵盖了多种手术器械类别。

采用Challenge IoU、IoU和mean class IoU(mc IoU)三种分割指标进行评估。