【SAM-Med2D】

本篇文章是个人看文献的一些总结和个人的想法,都是个人看过文章之后的理解,不保证一定是对的,如果我的理解有错,欢迎纠正。

(2023.8.30)

医学图像分割有助于医生准确诊断和治疗。

现有的方法通常受限于特定模态、器官或病变,难以广泛应用于不同的临床场景。

SAM是一个在自然图像分割上表现出色的模型,但在医学图像上直接应用效果不佳,原因在于自然图像与医学图像之间的领域差异。

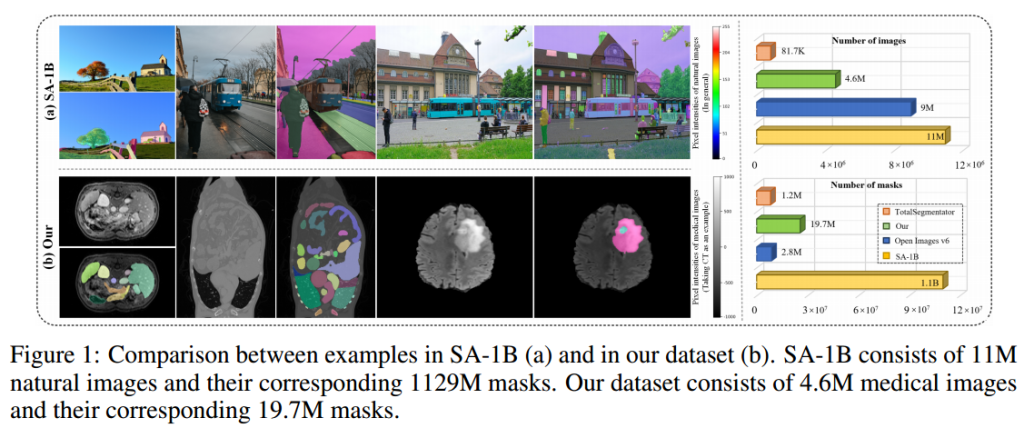

本文收集并整理了约4.6M图像和19.7M掩码,构成了一个大规模的多模态、多对象的医学图像分割数据集。

数据预处理方面,对3D数据集进行了标准化处理,提取了所有切片图像及其对应的掩码,并进行了适当的筛选以保证图像质量。对于2D数据集,进行了像素值范围的检查,并保存为PNG格式。

对于包含多个类别的掩码,生成多个单一类别的掩码,并将包含多个连通组件的掩码分割成单个连通组件的掩码,以增加数据多样性。

本文收集的数据集来源和组成部分:

本文对SAM进行了全面的微调,包括边界框、点提示、掩码提示,以适应医学图像分割的多样化需求。

本文使用9个MICCAI2023数据集来评估SAM-Med2D的泛化能力,以确保其在未知医学图像环境下的准确分割。

SAM-Med2D的模型框架如下:

在微调过程中,冻结了原始图像编码器的所有参数,并在每个Transformer块中添加了适配器层。可以在不增加计算成本的情况下将医学领域知识整合进图像编码器。

使用点、框和掩码信息对提示编码器进行微调,以增强其在医学成像领域的适用性。同时通过交互训练更新掩码解码器的参数。

SAM-Med2D的评估:

使用SAM作为baseline模型,选择Bbox和Points两种直观的提示模式来评估SAM-Med2D的性能。

在10种不同的医学图像模态上评估SAM-Med2D的性能。

在不同的解剖结构和31个主要器官上进行评估,以深入了解SAM-Med2D在不同场景中的性能差异。

在9个MICCAI 2023数据集上测试SAM-Med2D,以验证其在新的医学图像数据上的泛化能力。

实验部分:

通过测试集上的实验结果,比较了SAM、仅微调掩码解码器的FT-SAM和SAM-Med2D的性能。SAM-Med2D在边界框提示模式下相比SAM取得了显著的性能提升。

评估了SAM-Med2D对于不同成像模态的性能,结果是SAM-Med2D在所有成像模态上均显著优于SAM。

在9个公开数据集上测试了SAM-Med2D的泛化能力,结果表明SAM-Med2D在两种提示模式下都展现出了更好的泛化性能。

定性比较通过视觉比较直接观察SAM和SAM-Med2D生成的分割掩码,展示了两种方法在不同模态和解剖结构上的表现。SAM-Med2D在边界定位上更清晰,更接近真实标注。SAM在定位目标区域上存在困难,而SAM-Med2D即使在单点交互下也能生成更准确的分割结果。