【Polyp-SAM++: Can A Text Guided SAM Perform Better for Polyp Segmentation?】

本篇文章是个人看文献的一些总结和个人的想法,都是个人看过文章之后的理解,不保证一定是对的,如果我的理解有错,欢迎纠正。

(2023.8.12)

到目前为止,SAM在分割任务中取得了很好的效果,越来越多的应用领域正在对SAM进行实现和实验分析。

具体到息肉分割,Zhou等人和Chen等人分别使用非提示SAM和自适应SAM取得了令人满意的结果。Polyp-SAM使用SAM来完成相同的任务。Roy等评估了SAM在器官分割任务中的零样本分割能力。

本文受此启发,进行了一个实验,看看文本引导的SAM (Polyp-SAM++)在各种困难情况下如何很好地分割结肠镜图像中的息肉。

由于Meta还没有正式发布SAM中的文本提示功能,本文使用了Language Segment-Anything,它使用Grounding-DINO根据文本提示生成边界框,最终将其送到SAM进行最终的分割掩码生成。

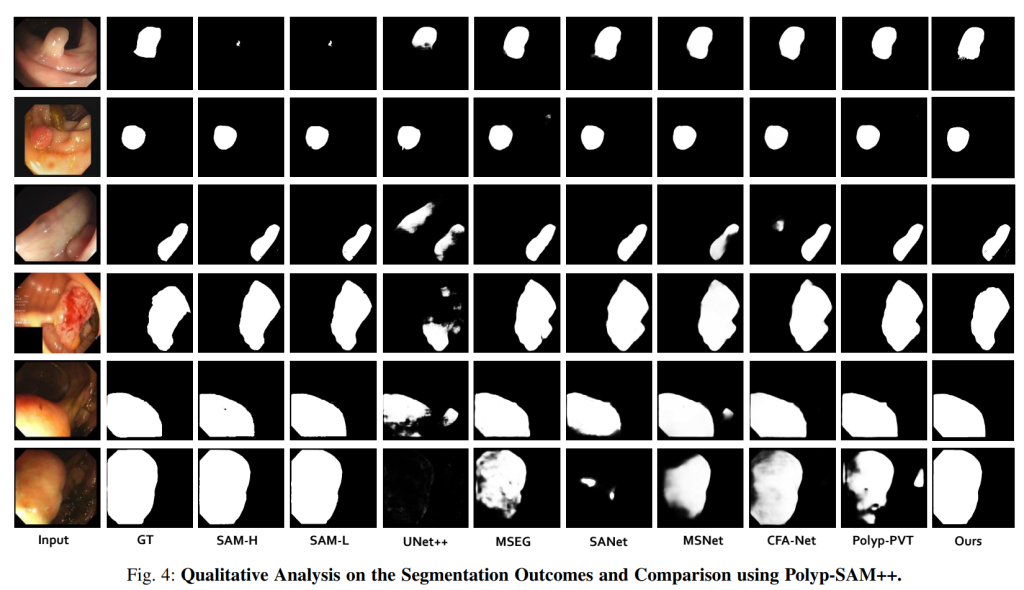

为了评估Polyp-SAM++的结果,本文对四个基准结肠镜数据集进行了定性和定量实验。

实验数据集:

Kvasir-SEG:该数据集包含1000对来自患者结肠镜检查期间胃肠道内部的图像,其中息肉与真实分割掩模一起存在。该数据集具有不同分辨率的图像。

CVC-300:该数据集包含60张包含息肉的图像。包含分辨率为500 × 574的图像。

CVC-ClinicDB:该数据集包含612张来自各种结肠镜检查视频的图像,分辨率为288 × 384。

评估指标:mDice、mIoU和Fm

实现细节:

通过手工制作的文本提示引导SAM模型,专注于在结肠镜图像中生成息肉的分割图。

使用零样本方法Grounding-DINO生成基于文本提示的边界框。

当SAM生成多个边界框时,根据真实分割选择最佳掩模的策略。

可以明显地看到,使用简单的文本引导来生成边界框有助于改进SAM模型,以便更好地理解要分割的内容,从而提高了整体分割性能。

根据分析,可以发现使用像SAM这样的模型的缺点在于定位目标,因为一旦实现了定位,SAM就能够有效地对其进行分割。文本引导不仅有助于输入图像中息肉的定位,而且有助于生成更好的分割图。

未来工作:

- 对其他数据集的评估

- 零样本边界框生成器增强

- 微调SAM

- 提示工程用于类似人类的监督

- 如果Meta正式发布了SAM的文本提示功能,建议使用Meta的文本提示进行性能评估