【MobileSAMv2: Faster Segment Anything to Everything】

本篇文章是个人看文献的一些总结和个人的想法,都是个人看过文章之后的理解,不保证一定是对的,如果我的理解有错,欢迎纠正。

(2023.12.15)

SegAny的计算瓶颈在于其图像编码器,而SegEvery的计算瓶颈主要在于对网格搜索密度要求较高的掩码解码器。

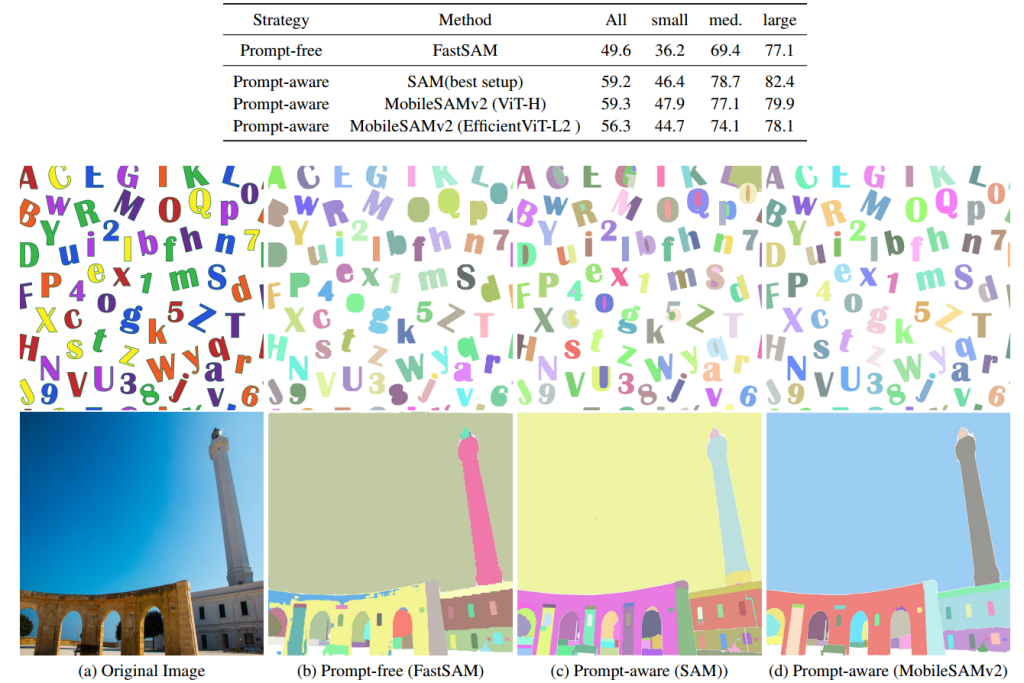

SegEvery不是一个提示的分割任务,因此掩码可以直接生成而不使用提示。MobileSAMv2通过对象发现直接生成最终的有效掩码可以减少掩码解码器的总时间,从而提高SegEvery任务的效率。通过实验发现,MobileSAMv2在数据集LVIS的零样本对象提议任务中有着较高的性能表现。MobileSAMv2不仅提高了SegEvery的速度,并且其兼容Mobile SAM中蒸馏的轻量级图像编码器,从而实现高效的SegAny和SegEvery任务。

MobileSAMv2的SegEvery框架包括两个阶段:对象感知提示采样(Object-Aware Prompt Sampling)和提示引导掩码解码(Prompt-guided Mask Decoding)。

对象感知提示采样:通过对象检测模型(YOLOv8)定位物体的边界框,但不进行分类。对象检测模型YOLOv8在SA-1B数据集的一小部分上进行训练,增强其泛化能力。

提示引导掩码解码:最终选择使用边界框作为提示的策略,因为它相比于点提示更具信息量,能够生成高质量的掩码,减少了歧义性,适合于高效的SegEvery。

最终模型速度有较好的提升: