【ASAM: Boosting Segment Anything Model with Adversarial Tuning】

本篇文章是个人看文献的一些总结和个人的想法,都是个人看过文章之后的理解,不保证一定是对的,如果我的理解有错,欢迎纠正。

(2024.5 vivo移动通信有限公司)

简介

SAM在特定应用中仍存在一些限制,需要寻找不影响其固有能力的增强策略。ASAM通过对抗性调优来提升SAM的性能。文章利用自然对抗性样本的潜力,通过使用稳定扩散模型,增强了SA-1B数据集的一小部分(1%),生成更具代表性的对抗性实例。经过微调的ASAM在各种分割任务中显示出显著改进,而无需额外的数据或架构修改。

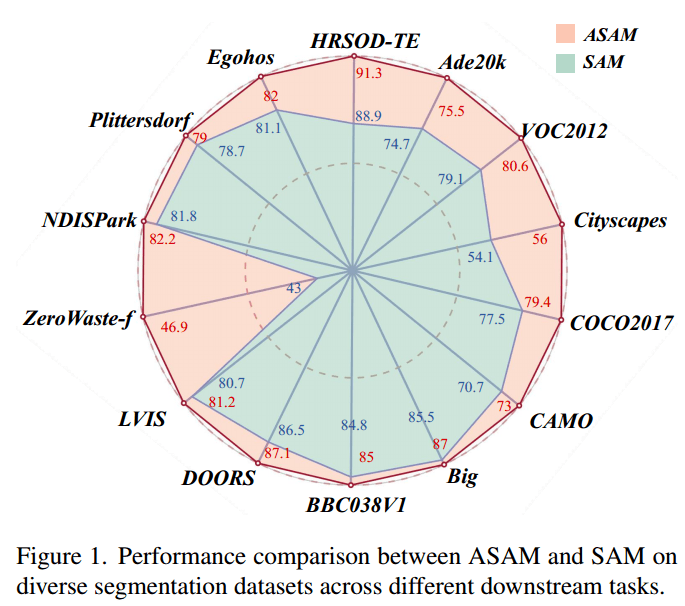

ASAM与SAM模型在不同数据集下的性能比较:

传统的方法主要通过微调模型参数或添加适配器模块来提升模型性能,但这些方法通常需要额外的数据和计算资源,增加了实际应用的复杂性和成本。此外,这些方法可能会对模型的泛化能力产生负面影响,使得模型在未见过的数据上表现不佳。

对抗性训练已经在自然语言处理(NLP)领域证明其有效性。这种方法通过生成对抗性样本,使模型能够在面对更具挑战性的输入时仍能保持高性能表现。

自然对抗性样本是一种新的数据增强策略,通过生成自然且逼真的对抗性图像,使模型能够在面对更复杂的输入时保持高性能。

生成的对抗样本不仅有逼真的视觉效果,还与原始注释掩码保持一致,减去了重新标注掩码的过程,保证了分割任务的完整性。

方法

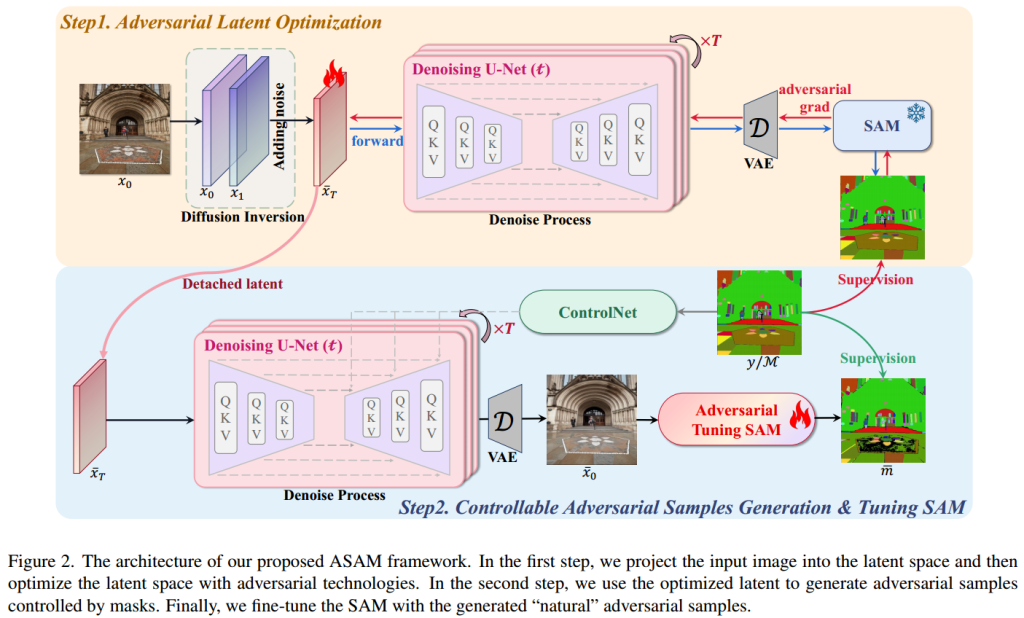

ASAM的主要目标是生成自然且逼真的对抗性样本,并利用这些样本进行微调,从而在不增加额外数据或修改模型架构的情况下,显著提升模型的分割性能。

自然对抗性样本生成方法

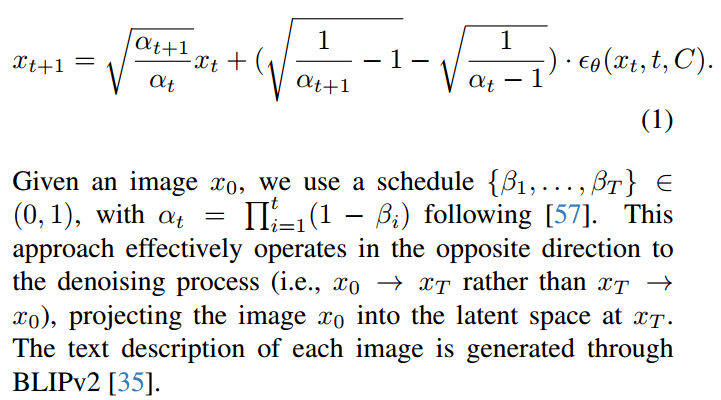

- 图像投影(Projecting Image to Diffusion Latent):利用生成模型(稳定扩散模型)来生成图像,将图像投影到低维流形上。

文章采用DDIM反演技术将图像投影到低维潜在空间,该技术利用CLIP文本编码器的提示P导出的条件嵌入C = ψ(P),其中的步骤为:

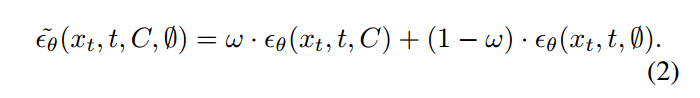

- 对抗性优化(Adversarial Optimization of Latent):在低维流形内,沿对抗方向进行优化,生成对抗性样本。

- 控制分支(Controllable Adversarial Samples Generation):控制分支负责在生成过程中,监控并调整对抗性样本,使其与原始掩码标签保持一致。

对抗性样本的微调

从SA-1B数据集中随机选取了一小部分(1%)的样本,用于生成对抗性实例。

在微调过程中,结合原始样本和对抗性样本,进行模型训练。通过这种方式,模型不仅能保持原有的分割能力,还能在面对更具挑战性的对抗性样本时,展示出更强的鲁棒性和适应性。

实验部分

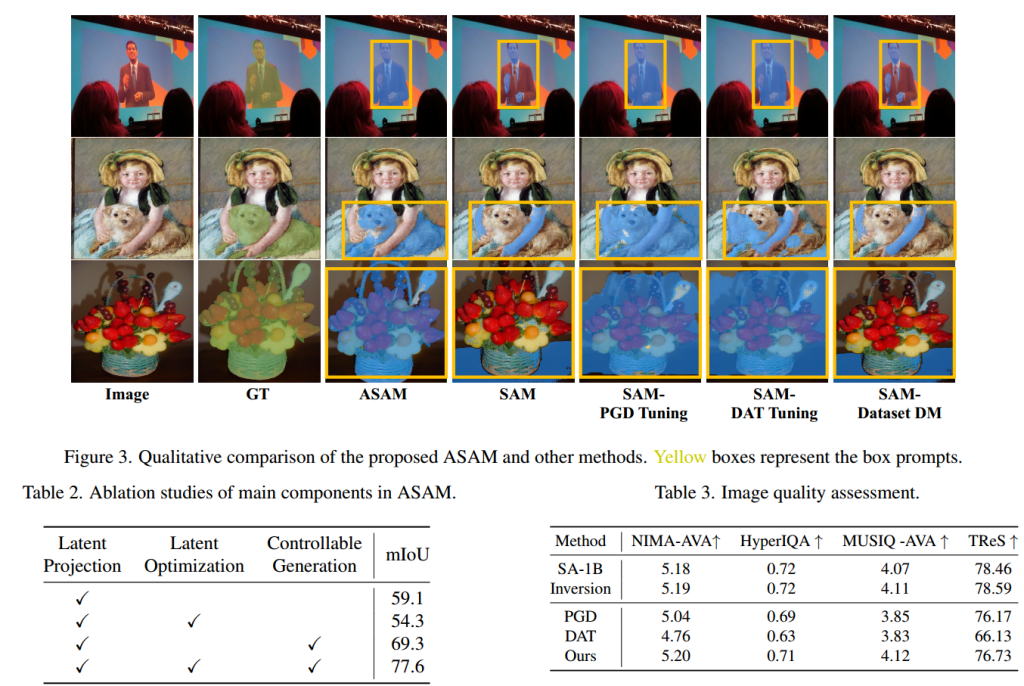

文章将ASAM与原始SAM、使用PGD调优进行微调的SAM、使用DAT调优进行微调的SAM以及使用通过DatasetDM生成的新数据进行微调的SAM进行了比较。

如图所示,ASAM明显优于其他调优方法。

其余调优方式的问题:SAM已经在大规模数据集上进行了训练,简单地在一些样本中添加噪声扰动或生成新的样本来调优SAM并不会给SAM带来明显不同的数据分布。并且重新调优可能会破坏原先训练良好的SAM参数。

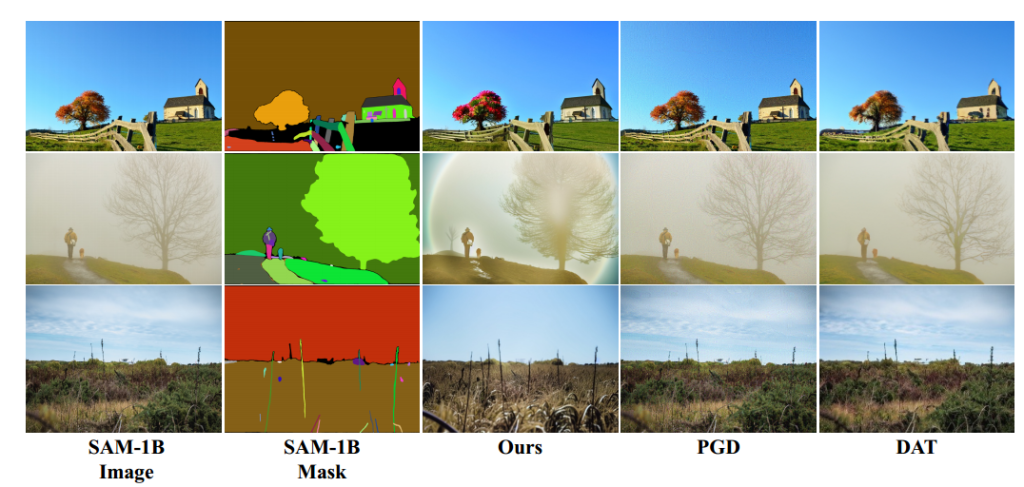

在原本SA-1B数据集掩码基础上生成的图像对比:

明显可以看出,在保证不改变图像分割掩码的基础上,本文的图像复杂程度更高。

实验结果显示ASAM在各个分割任务和不同数据集(COCO、ADE20K、和Cityscapes等)中均取得了显著的性能提升。

局限性

本文提出的方法的局限性:

(1)虽然成功生成了自然且逼真的对抗性样本,但生成过程仍然具有一定的复杂性和计算成本。

(2)对抗性训练可能会影响模型的可解释性。