【AI models collapse when trained on recursively generated data】

本篇文章是个人看文献的一些总结和个人的想法,都是个人看过文章之后的理解,不保证一定是对的,如果我的理解有错,欢迎纠正。

(牛津大学、剑桥大学、伦敦帝国理工学院、多伦多大学、多伦多矢量研究所、爱丁堡大学 2024.7.24)

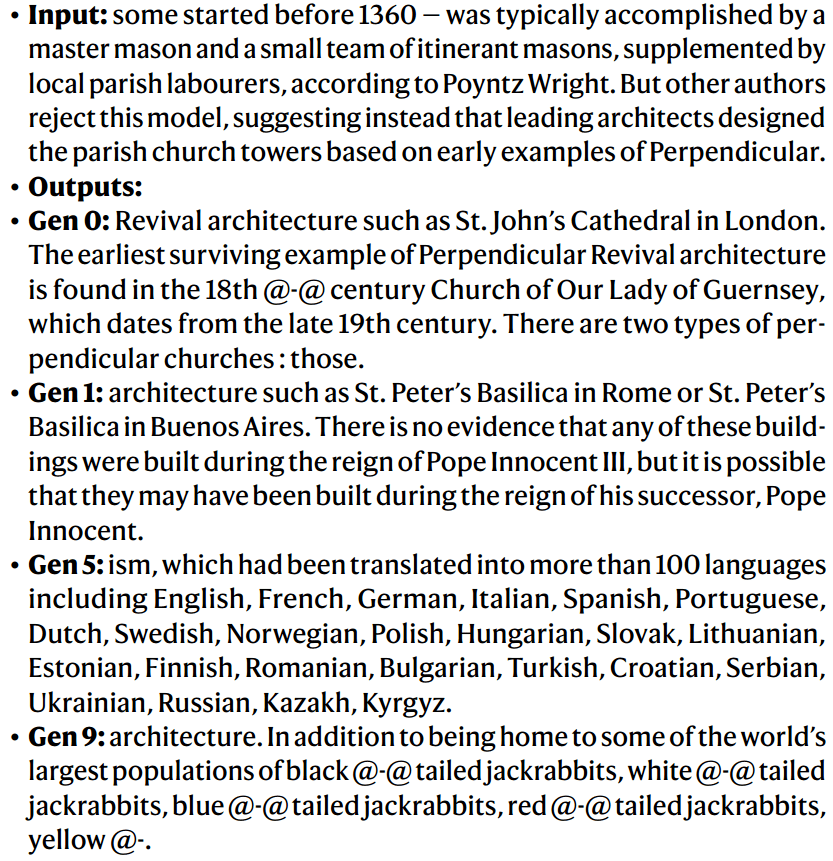

随着大语言模型生成的内容越来越多地被用于训练数据,这可能导致模型性能下降,甚至出现“模型崩溃”(model collapse)现象。

模型崩溃是指在训练过程中,由于模型生成的数据污染了下一代模型的训练集,导致模型逐渐忘记真实的底层数据分布,最终导致模型性能退化。

早期模型崩溃表现为模型开始丢失关于分布尾部的信息;晚期模型崩溃则是模型收敛到与原始分布相似度极低的分布,通常伴随着显著降低的方差。

导致模型崩溃的原因:

统计近似误差:由于样本数量有限,导致在重采样的每一步都有可能丢失信息。功能表达性误差:由于模型的表达能力有限,可能导致在原始分布的支持之外引入非零概率,或在原始分布的支持内引入零概率。

功能近似误差:主要源于学习过程的局限性,例如梯度下降的结构偏差或目标函数的选择。

文章通过在变分自编码器(VAEs)、高斯混合模型(GMMs)和LLMs上的实验,展示了模型崩溃的普遍性。

在语言模型的实验中,作者使用了OPT-125m因果语言模型,并在wikitext2数据集上进行了微调。

文章讨论了模型崩溃对大语言生成模型学习动态的影响,强调了保持对原始数据源的访问以及获取非大语言模型生成数据的重要性。

随着大语言模型生成的内容在互联网上的普及,将越来越难以训练新的大语言模型版本,除非能够访问在技术普及之前从互联网上爬取的数据或直接获取人类生成的大规模数据。

文章提示研究者们要注意模型奔溃的问题,并且确保模型可以获取真实人类的交互数据。不过并不是在训练大模型的时候完全不要使用AI生成的数据,而是要时刻筛选AI生成的数据,确保数据的可用性,并且时刻观察模型的迭代性能。如果条件允许的话,最好将AI生成的数据与人类的数据区分开来,在训练模型的时候混合两种数据进行训练。